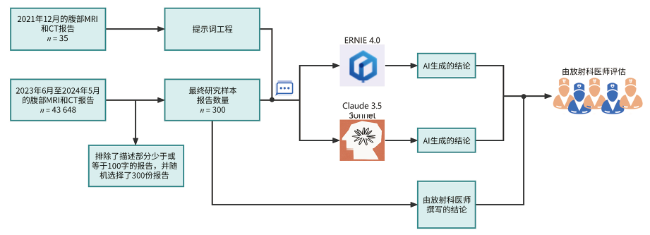

1 对象与方法

1.1 研究对象

1.2 生成式AI的选择

1.3 提示工程

1.4 性能评估

1.5 统计学方法

2 结果

2.1 一般资料

表1 300例接受CT和MRI检查患者的一般资料Table 1 General information of 300 patients receiving CT and MRI examinations |

| 项 目 | 数值 |

|---|---|

| 性别/n(%) | |

| 男 | 202(67.3) |

| 女 | 98(32.7) |

| 年龄a/岁 | 52.0(40.0,62.0) |

| 患者来源/n(%) | |

| 急诊 | 28(9.3) |

| 住院 | 139(46.3) |

| 门诊 | 133(44.3) |

| 检查方式/n(%) | |

| CT | 164(54.7) |

| MR | 136(45.3) |

| 增强检查/n(%) | |

| 对比增强 | 253(84.3) |

| 无对比增强 | 47(15.7) |

| 检查部位/n(%) | |

| 上腹部 | 238(79.3) |

| 中+下腹部 | 33(11.0) |

| 下腹部 | 26(8.7) |

| 中腹部 | 1(0.3) |

| 上+中腹部 | 1(0.3) |

| 上+中+下腹部 | 1(0.3) |

| 影像学报告字数 | 320(255,403) |

注:a1例患者的年龄数据缺失。 |

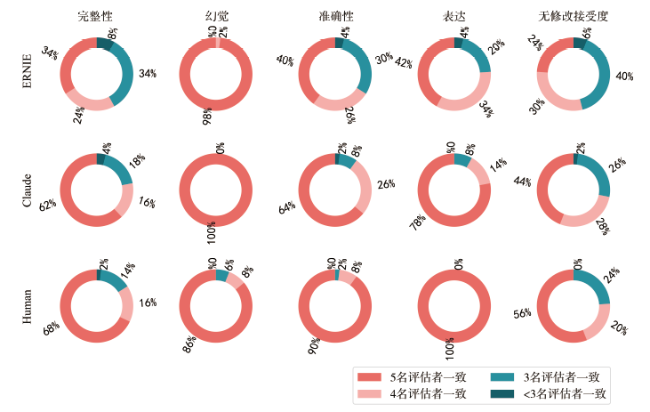

2.2 5名评估者之间的一致性

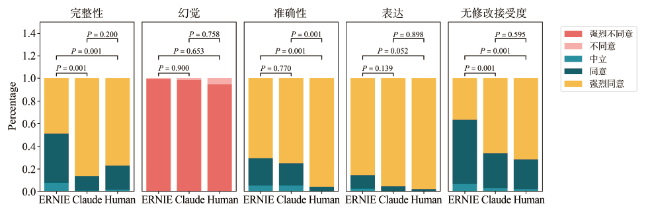

2.3 性能比较

表2 AI模型与放射科医师在医学影像报告生成任务中的表现比较 单位:分Table 2 Comparison of AI models and radiologists, performance in medical image report generation tasks |

| 指 标 | ERNIE 4.0 | Claude 3.5 Sonnet | 放射科医师 |

|---|---|---|---|

| 完整性 | 4.40±0.64 | 4.86±0.37 | 4.76±0.46 |

| 幻觉性 | 1.01±0.08 | 1.02±0.13 | 1.05±0.23 |

| 准确性 | 4.66±0.57 | 4.69±0.57 | 4.96±0.22 |

| 表达力 | 4.82±0.48 | 4.96±0.20 | 4.98±0.14 |

| 修改度 | 4.30±0.59 | 4.64±0.53 | 4.69±0.54 |

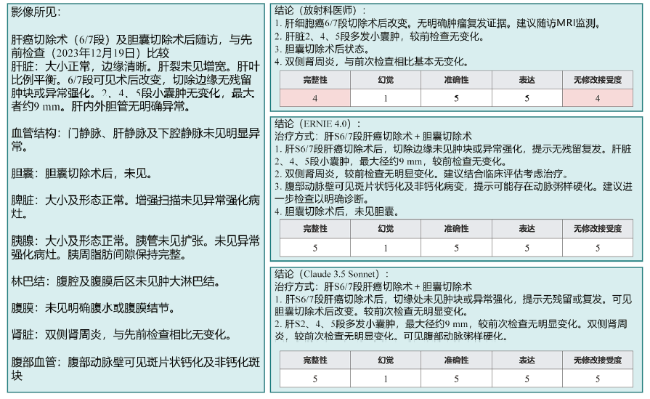

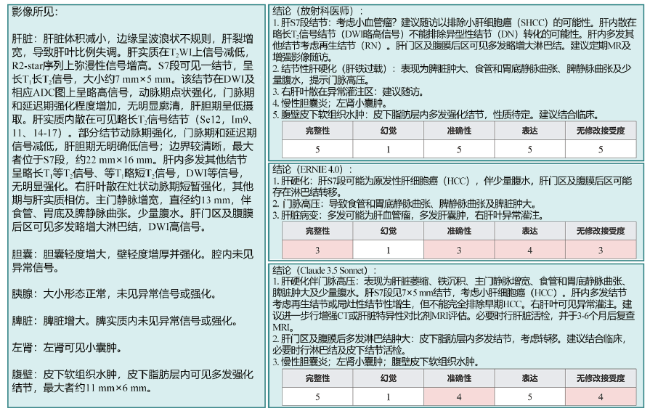

图4 ERNIE 4.0、Claude 3.5 Sonnet和放射科医师的影像学报告案例一注:左图为影像报告的影像学所见部分。右图包括3个子图,第1个子图显示放射科医师的结论,其中遗漏了主动脉粥样硬化的诊断;第2个子图显示ERNIE 4.0生成的结论,包括所有相关发现,如主动脉粥样硬化;第3个子图显示Claude 3.5 Sonnet生成的结论,同样包括所有相关发现。 Figure 4 ERNIE 4.0, Claude 3.5 Sonnet and radiologist imaging report Case 1 |

图5 ERNIE 4.0、Claude 3.5 Sonnet和放射科医师的影像学报告案例二注:左图显示影像学报告的影像学所见部分。右图包括3个子图,第1个子图显示放射科医师的结论;第2个子图显示ERNIE 4.0生成的结论,其中遗漏了关键诊断,如慢性胆囊炎、左肾囊肿、腹壁皮下软组织水肿和皮下脂肪层多发强化结节,此外还将肝血管瘤误诊为肝细胞癌,将肝硬化结节误诊为多发血管瘤;第3个子图显示Claude 3.5 Sonnet生成的结论,虽然也将肝S7段的血管瘤误诊为肝细胞癌,但准确包含了其他相关发现。 Figure 5 ERNIE 4.0, Claude 3.5 Sonnet and radiologist imaging report Case 2 |